Command R+ — нейросеть для RAG и автоматизации кода на русском через Vlex AI

Command R+ представляет собой корпоративную языковую модель, оптимизированную для работы с большим объёмом контекста и для интеграции в RAG рабочие процессы. В этой статье даётся аналитический обзор модели, сравнение с ключевыми конкурентами, практические сценарии использования и подробная инструкция по быстрому тесту через агрегатор нейросетей Vlex AI. Для фактической части я опирался на официальную документацию Cohere и независимые обзоры с результатами тестов.

Решения на базе LLM перестали быть экспериментом и стали частью продуктовой логики служб поддержки, аналитики и автоматизации разработки. Решение о выборе модели должно основываться на сочетании точности, стоимости и удобства интеграции. Здесь показано в каких ситуациях Command R+ даёт преимущество и как минимизировать риски при внедрении через Vlex AI.

Что такое Command R+

Command R+ это модель, ориентированная на бизнес задачи с большими контекстами и требованием точного цитирования источников. Она доступна в актуальной версии 08-2024 и поддерживает длинные контексты до 128k токенов, что делает её подходящей для корпоративных RAG решений, анализа документов и задач автоматизации кода. Для корпоративного тестирования и быстрого сравнения используйте Vlex AI где доступны готовые шаблоны промтов и инструмент для подключения векторных баз.

Ключевые технические характеристики и возможности

Масштаб и контекстное окно

Модель представлена в архитектуре порядка сотен миллиардов параметров и может обрабатывать контексты до 128 000 токенов в ряде поставок. Это ключевое преимущество для задач где требуется сохранять большой объём документов в едином запросе.

Поддержка RAG рабочих процессов

Command R+ рассчитана на интеграцию с векторными хранилищами и гибридным поиском. Модель умеет корректно работать с фрагментированными входными данными и давать ответы с указанием источников при корректной настройке пайплайна.

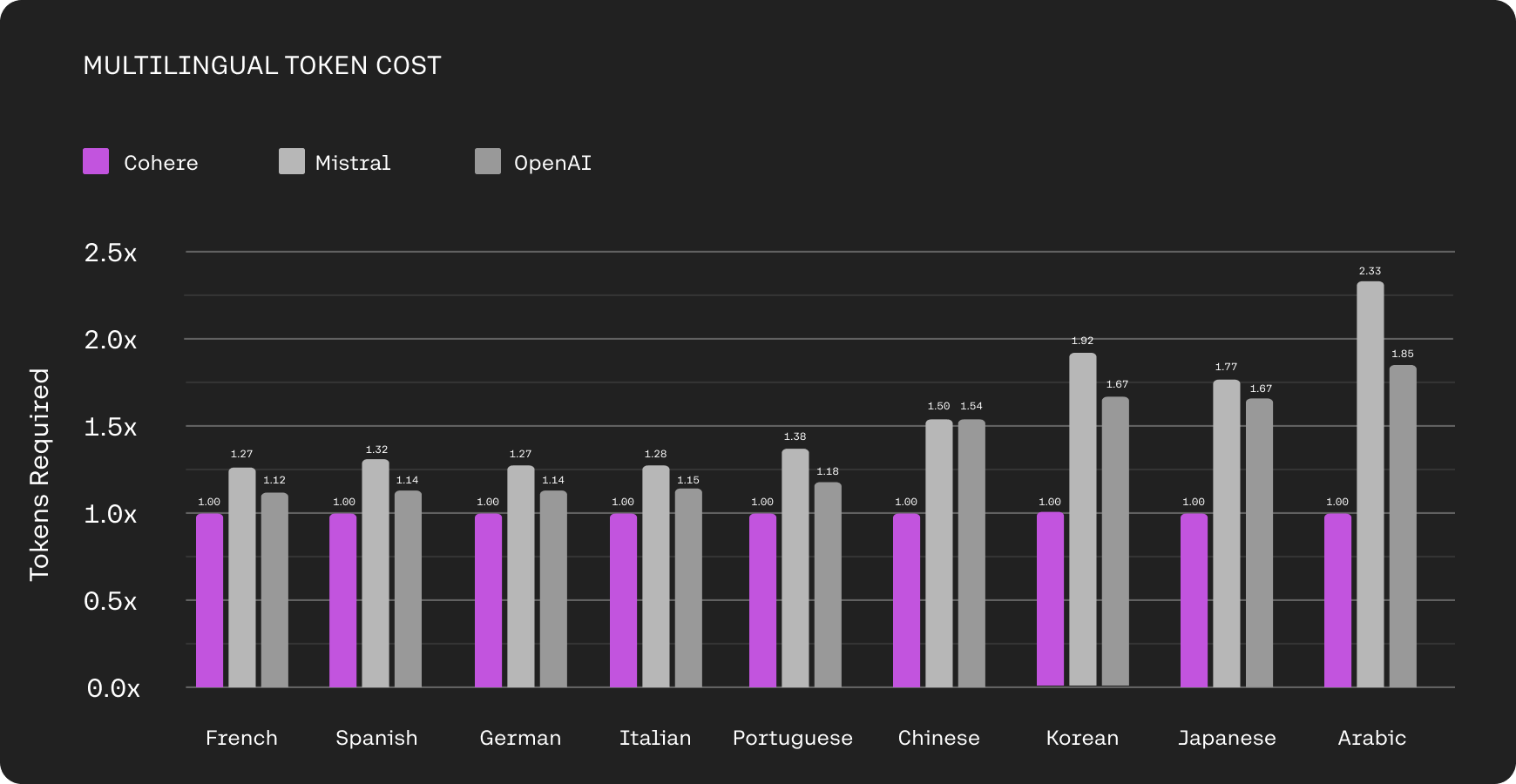

Языковая поддержка и домены

Модель демонстрирует устойчивую работу по ключевым мировым языкам и дополнительно улучшена для ряда локализаций. Это делает её подходящей для глобальных продуктов и региональных решений.

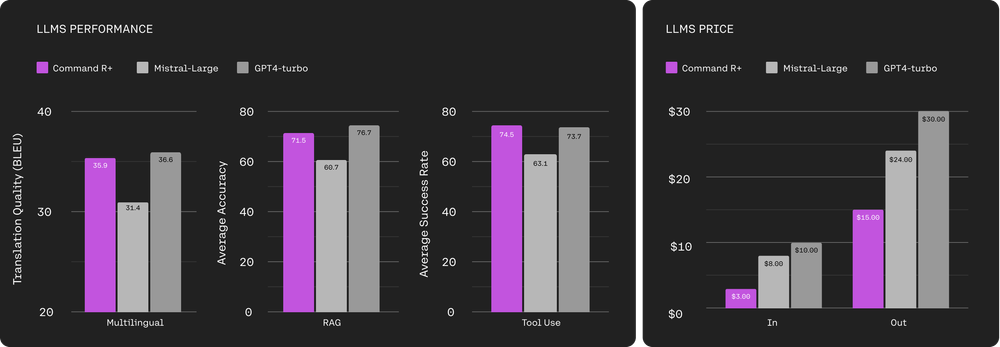

Стоимость вызовов и экономическая логика

Прайс модели у Cohere публикуется разными тарифами в зависимости от версии и числа токенов. На момент составления обзора официальный прайс указывает на значительное отличие в цене ввода и вывода токенов между версиями и на выгодность использования оптимизированных сборок для частых массовых запросов. Перед запуском в продакшн рекомендую сравнить расчёт стоимости на вашей нагрузке с калькулятором в Vlex AI.

Что нового в версии 08-2024 и чем это важно

Обновление 08-2024 включает улучшения в стабильности генерации на длинных контекстах, повышенную точность при извлечении фактов и улучшения в модуле цитирования источников. На практике это значит что RAG сцена с большими документами будет отдавать более согласованные ответы и меньше требовать постобработки. Для задач корпоративной аналитики это сокращает время на валидацию и повышает пригодность автоматизированных отчётов.

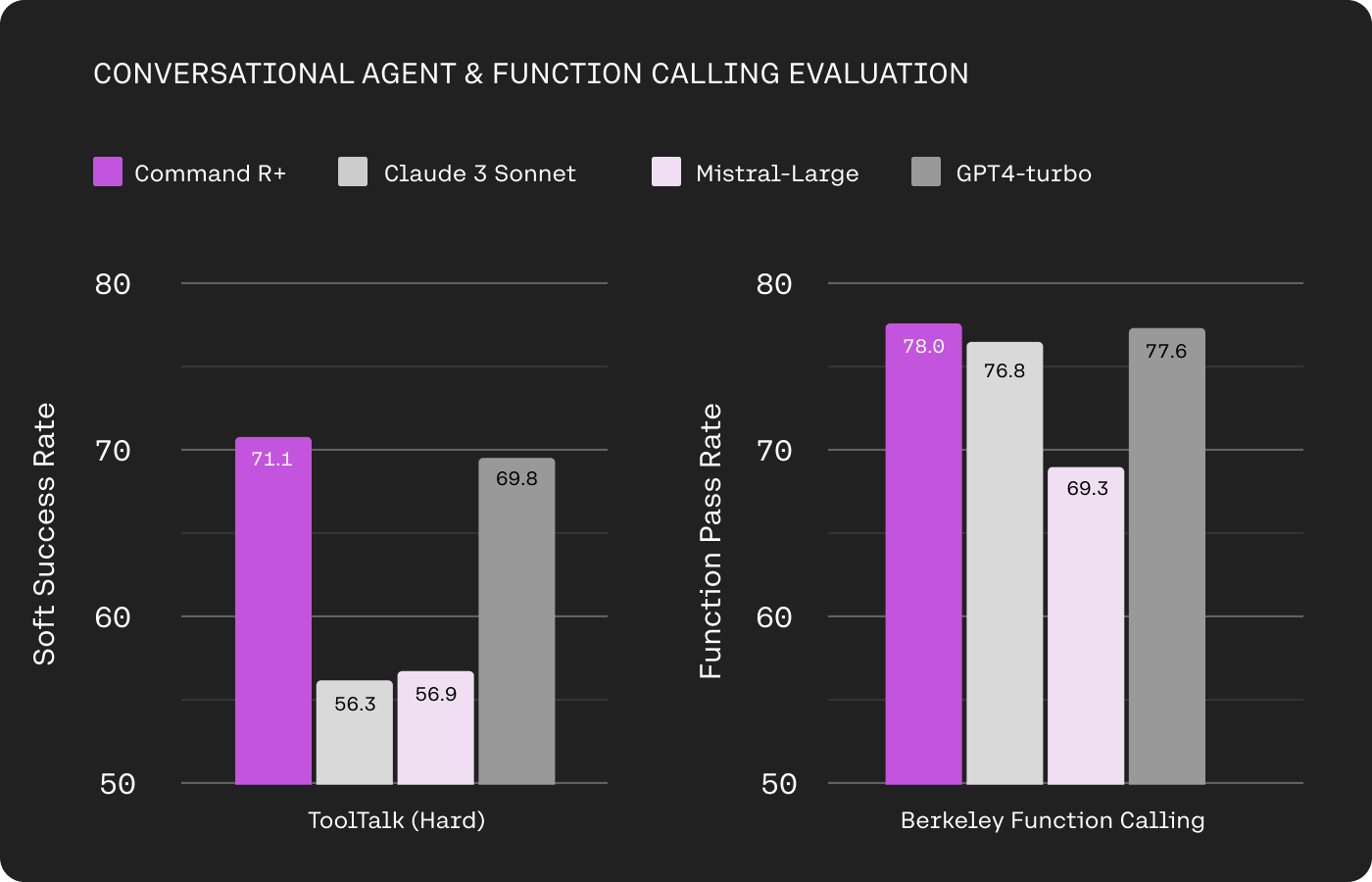

Сравнение с конкурентами и результаты бенчмарков

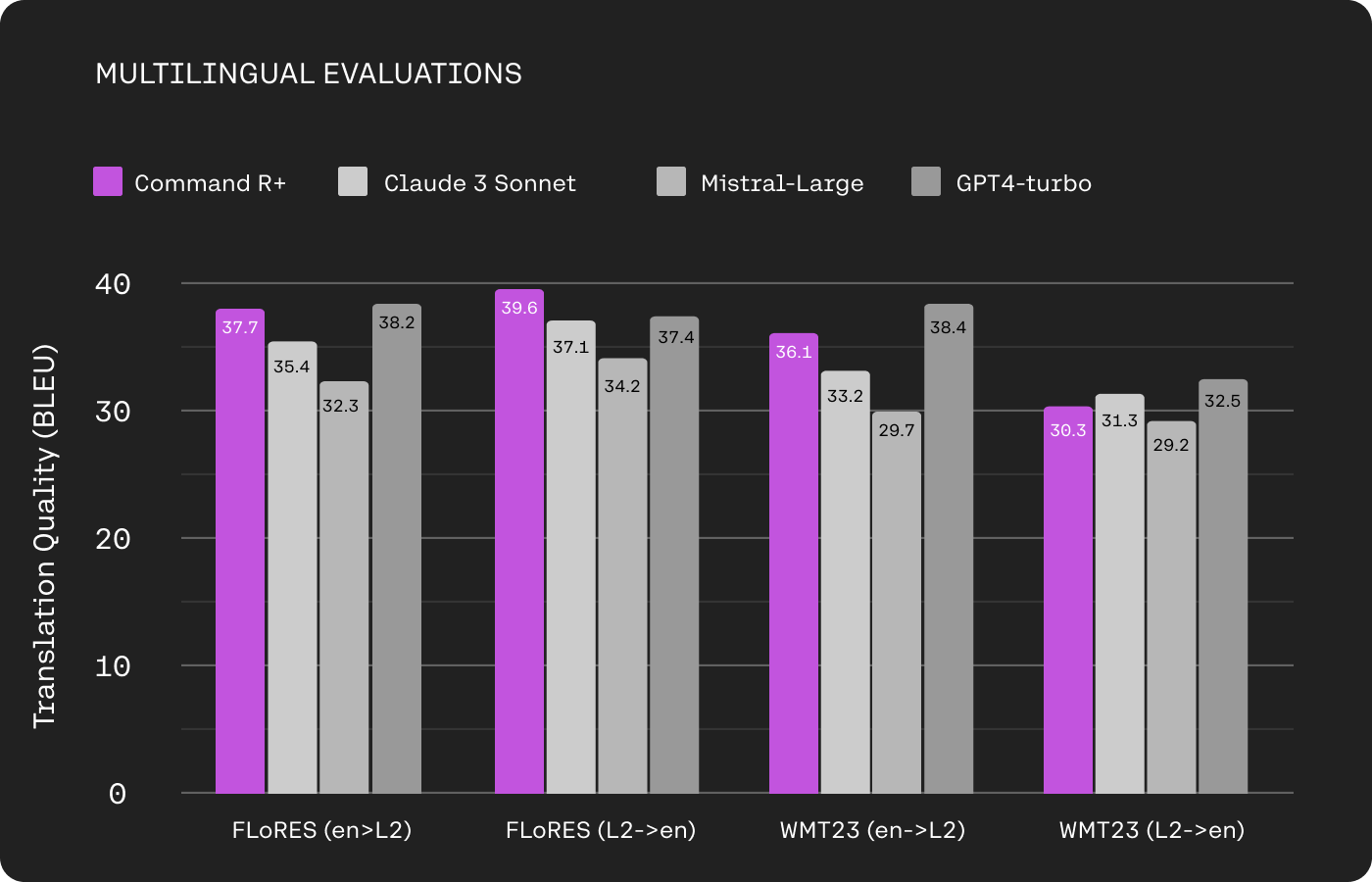

Независимые обзоры и аналитика показывают что в ряде прикладных задач Command R+ показывает конкурентоспособные результаты по сравнению с крупными моделями вроде GPT-4. В то же время универсальные бенчмарки демонстрируют смешанную картину и подчеркивают важность контроля эксперимента при выборе модели под конкретную задачу. Реальные тесты лучше проводить на ваших данных и метриках.

Классические сценарии где Command R+ эффективна

• Корпоративный поиск и ответы по документам с поддержкой цитирования и длинной истории.

• Автоматическая генерация документации и рефакторинг кода при условии дополнительной валидации.

• Службы поддержки и интеллектуальные помощники с контекстом пользователя на уровне сессий.

• Подготовка аналитических сводок из больших массивов текстовой информации.

Для каждого из перечисленных кейсов Vlex AI предлагает инструменты для быстрого развертывания RAG пайплайна и готовые шаблоны промтов что ускоряет переход от прототипа к рабочему сценарию.

Риски и ограничения которые важно учесть

• Модель может неверно связывать источники если пайплайн настроен некорректно.

• Для критичных решений всегда нужен слой валидации с контролем фактов и метриками качества.

• Динамические или очень узкоспециализированные сценарии требуют тонкой настройки и возможно дообучения.

При работе через Vlex AI можно настроить этапы постобработки и встроить проверку фактов что снижает операционные риски.

Пошаговый план тестирования Command R+ через Vlex AI

Шаг 1

Зарегистрируйтесь на сайте Vlex AI и войдите в личный кабинет.

Шаг 2

Откройте каталог моделей и выберите Command R+ с пометкой версии 08-2024.

Шаг 3

Подготовьте небольшой корпус документов для RAG теста и загрузите в векторное хранилище внутри платформы.

Шаг 4

Используйте готовые шаблоны промтов во Vlex AI для RAG и для задач по коду чтобы получить эталонные отклики.

Шаг 5

Соберите метрики точности, скорости и стоимости вызовов и сравните с альтернативами в эксперименте A/B.

Этот план экономит время при первичной валидации и позволяет быстро увидеть насколько модель подходит под конкретную задачу.

Промтовая инженерия с шаблонами Vlex

Промтовая инженерия — ключевой элемент при внедрении LLM в продуктовые сценарии. Во Vlex есть готовые шаблоны для составления профессиональных промтов, которые можно использовать как стартовую базу для RAG, задач по коду, автоматизации поддержки и маркетинговых генераций. Эти шаблоны помогают стандартизировать формат запросов, управлять контекстным окном и явно задавать требования к цитированию источников.

Как работать с шаблонами во Vlex (рекомендованный подход):

- Выберите шаблон по задаче (RAG, код, сводки, FAQ).

- Подставьте метаданные и краткий контекст — укажите требуемый формат ответа и правила цитирования.

- Прогоните контрольную выборку запросов и соберите метрики (accuracy, latency, token-cost).

- Сделайте итерацию: добавьте примеры в few-shot секцию или уточните инструкции в шаблоне.

- Проведите A/B тест с альтернативными промтами и настройками модели; выберите вариант с оптимальным соотношением точности и стоимости.

Совет для публикаций и инструкций: указывайте, что шаблоны Vlex — это рабочая отправная точка, а не окончательное решение; обязательна адаптация под конкретные данные и проверка первых нескольких сотен ответов вручную.

Тарифы Vlex AI для тестирования и внедрения

Бесплатный 0₽ 50 токенов для первичного теста и понимания как всё работает.

Начальный 799₽ 1000 токенов для регулярного использования и небольших задач.

Продвинутый 2499₽ 3000 токенов для профессиональных проектов и активной работы.

Эти пакеты позволяют гибко оценить модель на вашей нагрузке и определить необходимый объём вычислений до перехода на корпоративные планы.

Во Vlex AI доступны профессиональные шаблоны для промтов которые покрывают стандартизированные сценарии RAG, генерации кода и SEO контент. Используйте их как базу и адаптируйте с учётом заполнения контекста и бизнес-правил.

Практические рекомендации для инженеров и менеджеров

• Запускайте реальные тесты на собственных данных а не на общих бенчмарках.

• Настройте мониторинг качества и расхода токенов сразу на этапе пилота.

• Включите этап ручной проверки для первых 1000 ответов чтобы откалибровать post processing.

• Применяйте шаблоны промтов Vlex AI чтобы быстро получить воспроизводимые примеры.

FAQ кратко

Как быстро начать тест в Vlex AI

Ответ зарегистрируйтесь на сайте Vlex AI выполните шаги из раздела тестирования и используйте бесплатный пакет 50 токенов.

Поддерживается ли Command R+ в облачных провайдерах

Ответ модель доступна в поставках через Azure и другие облачные каталоги что упрощает корпоративный деплой.

Заключение

Command R+ представляет взвешенную опцию для компаний которым нужна модель для работы с длинными контекстами и для RAG решений. Рекомендую проводить пилот на собственных данных и использовать Vlex AI для ускорения тестирования и сравнения. Для принятия решения начните с бесплатного пакета и оцените точность и стоимость на вашей нагрузке. Если необходима помощь на этапе пилота обращайтесь в группу в Telegram @vlexai или в службу поддержки @supprtbots. Сайт платформы доступен по адресу Vlex AI https://vlex-ai.io/